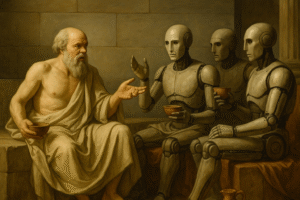

Mentre le intelligenze artificiali (AI) riversano parole sempre più penetranti in ogni angolo pubblico e privato delle società umane e i loro stregoni si lanciano in progetti sempre più audaci, cresce l’ansia di sapere quanto possiamo fidarci di quelle parole, se esse possano contribuire alla conoscenza o – come afferma qualcuno – siano solo un abbagliante inganno, essendo prive di qualsivoglia significato.

La conoscenza ha un rapporto molto intimo con la verità. Per i logici, se effettivamente sappiamo qualcosa, quel qualcosa deve essere vero. Detto in altri termini: se quello che credevamo di sapere si rivela falso, in effetti la nostra non era conoscenza, ma solo opinione (doxa). Se invece è vero, la nostra credenza può essere ipso facto promossa al rango di conoscenza (episteme). Messa così, se gli enunciati proferiti dai nostri chatbot fossero fattualmente veri, i logici non potrebbero negare che essi veicolano autentiche conoscenze per chi sia disposto a crederci.

Gli epistemologi, tuttavia, fin dai tempi del Teeto, hanno osservato che la conoscenza deve anche essere giustificata: non possiamo dire di sapere che le cose stanno in un certo modo solo perché – incidentalmente – stanno in effetti in quel modo: dobbiamo anche ragionevolmente motivarlo. Il problema si pone dunque in questi termini: possiamo dire che sappiamo che le cose stanno in un certo modo perché ce lo ha detto un chatbot? Oppure la provenienza algoritmica (perfino macchiata di statistica) dell’informazione la destituisce di fondamento, si trattasse anche della verità più palmare, tipo 2+2=4?

Posso ritenere di sapere che Rrose Sélavy fosse uno pseudonimo en travesti di Marcel Duchamp se me lo ha detto GPT? Il summenzionato qualcuno sembra orientato per il no:

L’epoca in cui viviamo non è affollata di falsità: è affollata di testi ben scritti che non significano nulla. Il rischio non è essere ingannati, ma non accorgersi più di cosa significhi davvero conoscere. (Walter Quattrociocchi, L’inganno perfetto dell’intelligenza artificiale: scrive bene ma non sa nulla. Corriere della Sera, 23 Luglio)

Cioè, sembra di capire: gli enunciati dell’AI non arrivano neanche a essere falsi, in quanto non significano nulla, e a maggior ragione non possono fondare alcuna conoscenza. Ma se leggo qualcosa su Wikipedia, scritto di proprio pugno da qualche benemerito umano contributore, posso invece crederci? E se poi scopro che il chatbot la notizia l’ha presa proprio da lì, come devo regolarmi? Il tema merita un approfondimento: è proprio il caso di domandarsi cosa significhi davvero conoscere, dove però quel davvero non riguarda l’informatica e le reti neurali ma l’umano commercio del sapere, con tutta la sua sociologica complessità.

Il problema del sapere, nella sua vastità, è ben trattato altrove. Qui però balza agli occhi una rara fallacia argomentativa, su cui vale la pena spendere due parole. Si tratta della negative authority fallacy, che consiste nel ritenere falsa un’affermazione perché non è sostenuta o approvata da un’autorità riconosciuta o da un gruppo autorevole. Insomma, è un ipse dixit col segno meno. Questa fallacia è uguale e contraria a quella di coloro i quali credono che una cosa è vera perché l’ha detta l’AI, mostrando che anche nello spazio del pensiero vale il principio di Newton: ad ogni sciocchezza corrisponde una sciocchezza uguale e contraria. Si può anche riconoscere l’impronta dell’argumentum ad hominem nella inedita variante dell’argumentum ad machina: una proposizione è vera o falsa non in base al suo contenuto, ma alla sua provenienza. Se la proposizione è fatta a macchina – poco importa come – allora deve essere gettata nel bidone del nonsense.

Sia gli argomenti ad hominem sia quelli ad machina si prestano al genere di facezie che Flaubert riservò a Bouvard e Pécuchet, due enciclopedici wannabe ossessionati dall’auctoritas e perciò votati al fallimento. Tuttavia, il tema è terribilmente serio, perché – piaccia o meno – l’AI sta rapidamente diventando il principale alimento della nostra dieta informativa, come dimostra un recente studio sull’impatto di Google AI Overview.

Noi sappiamo di non sapere, mentre i nostri automi non sanno di sapere, e a dirla tutta neanche si pongono il problema. Ma loro continueranno a rispondere perché noi continueremo a domandare. Toccherà a noi, dunque, decidere chi o cosa ascoltare. Come è sempre stato, d’altronde.